검색결과 리스트

글

2024년의 끝을 앞두고 사라지다 - 중앙선 북영천역(+화본역)

좌충우돌 여행기/국내여행

2024. 12. 16. 20:06

일상생활 중에 언제나 여행계획을 짜보지만 날씨나 다른 일정등으로 연말까지 미루고 미루다 촉박하게 일정을 정하고 여행을 다녀오는 패턴이 매년 이어지고 있었는데 올해 또한 그렇게 되었습니다.

이번 포스팅에서는 2024년을 끝으로 영업을 마치게 되는 중앙선 북영천역을 다녀오게 되었습니다.

지난 11월말 안동에서 무궁화호를 타고 북영천역에 도착하였을 때였습니다.

선로 옆에 차후 하행선이 될 선로쪽에만 플랫폼을 만들어 둔 모습입니다.

플랫폼은 3량짜리 무궁화호가 설 만큼의 길이만큼 만들어져 있었습니다.

그래도 간이 대기 장소가 마련되어 나름 역의 구실을 하고 있었습니다.

북영천역은 동해-동대구 구간을 운행하는 무궁화호만 정차합니다.

제가 타고 온 동대구행 무궁화호 열차는 영천삼각선을 통해 바로 하양역으로 가기에 영천역을 가지 않습니다.

그래서 북영천역은 동해(구 강릉) - 동대구 구간을 운행하는 무궁화호 승객을 위해 만들어진 역입니다.

이 역은 왕복 2회(편도 4회)의 열차만 정차합니다. 동해-동대구 구간을 운행하는 무궁화호가 전부인 것이지요.

역 내부는 총 3개의 선로가 놓여져있습니다.

열차 운행 시간을 보면 평소에 이 역을 이용하기 어려운 시간대의 열차가 대부분입니다.

그래도 영천에 방문하고자 하는 승객을 위해 열차는 이 역에 정차해왔습니다.

이 곳에서 영천을 가는 열차도 이 곳을 통과하지면 이 역에 정차하지 않습니다.

왜냐하면, 이 역보다 영천역에서 더 많은 열차들이 정차를 하고

승객 입장에서 조금이나마 다양한 행선지가 있는 영천역을 더 선호할 것입니다.

그러기에 북영천역은 영천역을 경유하지 못하는 동해-동대구 구간 운행 열차의 여객취급만 합니다.

내년에는 동해-동대구 무궁화호 승객을 위해 운영되던 북영천역이 여객 취급을 중단합니다.

코레일의 공식 입장은 북영천-영천 이원화된 역 운영을 영천역으로 일원화 하는 것이 목적이라 합니다.

제 생각엔 코레일의 입장에서 북영천역 운영이 계륵같이 느껴졌으리라고 봅니다.

영천에 방문하고자 하는 고객들에게 북영천이라는 선택지를 지금껏 유지해 왔지만 실제 승객이 많지 않았고

중앙선 전구간의 복선전철화가 완료되어 지금보다 영천을 경유하는 열차편이 더 많아질테니

코레일의 입장에서는 북영천역의 여객취급을 계속 할만한 매리트가 없을만합니다.

북영천역에서 하차한 승객들이 모두 역을 빠져나가면

영천역에 있는 직원이 CCTV를 통해 모든 승객이 빠져나간 역 출입문을 폐쇄합니다.

이렇게 거대한 폴사인이 없었다면 사람들은 북영천의 존재를 알 수 있었을까요?

2024년 12월 14일. 이번에는 북영천역에서 열차를 탑승하기 위해 다시 방문하였습니다.

내일(2024년 12월 15일)을 끝으로 북영천역은 여객취급을 더이상 하지 않게 됩니다.

이제 영천역에서도 KTX를 타고 서울과 부산을 갈 수 있게 되었습니다.

결국 북영천역은 KTX는 커녕 ITX의 여객도 취급하지 못하고 더이상 승객을 받지 않게 됩니다.

열차가 정차하기 30분 전부터 출입문을 열어둡니다.

내일 오전을 끝으로 북영천역에 열차는 더이상 정차하지 않으며 한동안 임시버스가 무료로 운행됩니다.

비록 북영천역을 이용하는승객은 많지 않았지만 이 곳을 종종 쓰던 고객들은 어떤 기억을 남겼을까요?

역 입구에서 타는곳까지는 생각보다 많이 걸어야 했습니다.

여객취급을 중단하는 북영천역은 이후에도 분기 구간에서 신호장으로서의 역할을 계속 수행합니다.

신녕역 또한 이번을 끝으로 여객취급을 중단하게 됩니다.

물론 지금까지 이 곳을 들렀던 무궁화호 열차는 계속 정상운행합니다.

앞으로 영천에서 동해까지 가기 위해서는 영천역에서 하루 1회 운행하는 무궁화호를 타는 선택지만 남게됩니다.

역 주변을 둘러보다 기관차 한 대가 지나갑니다.

기관차가 멈칫하며 정지하더니 맞은편에서 열차가 나타납니다.

이 열차를 타고 저는 동대구역으로 이동할 것입니다.

그렇게 열차가 들어오고

열차는 요란한 소리를 내며 가던 길을 멈추어섭니다.

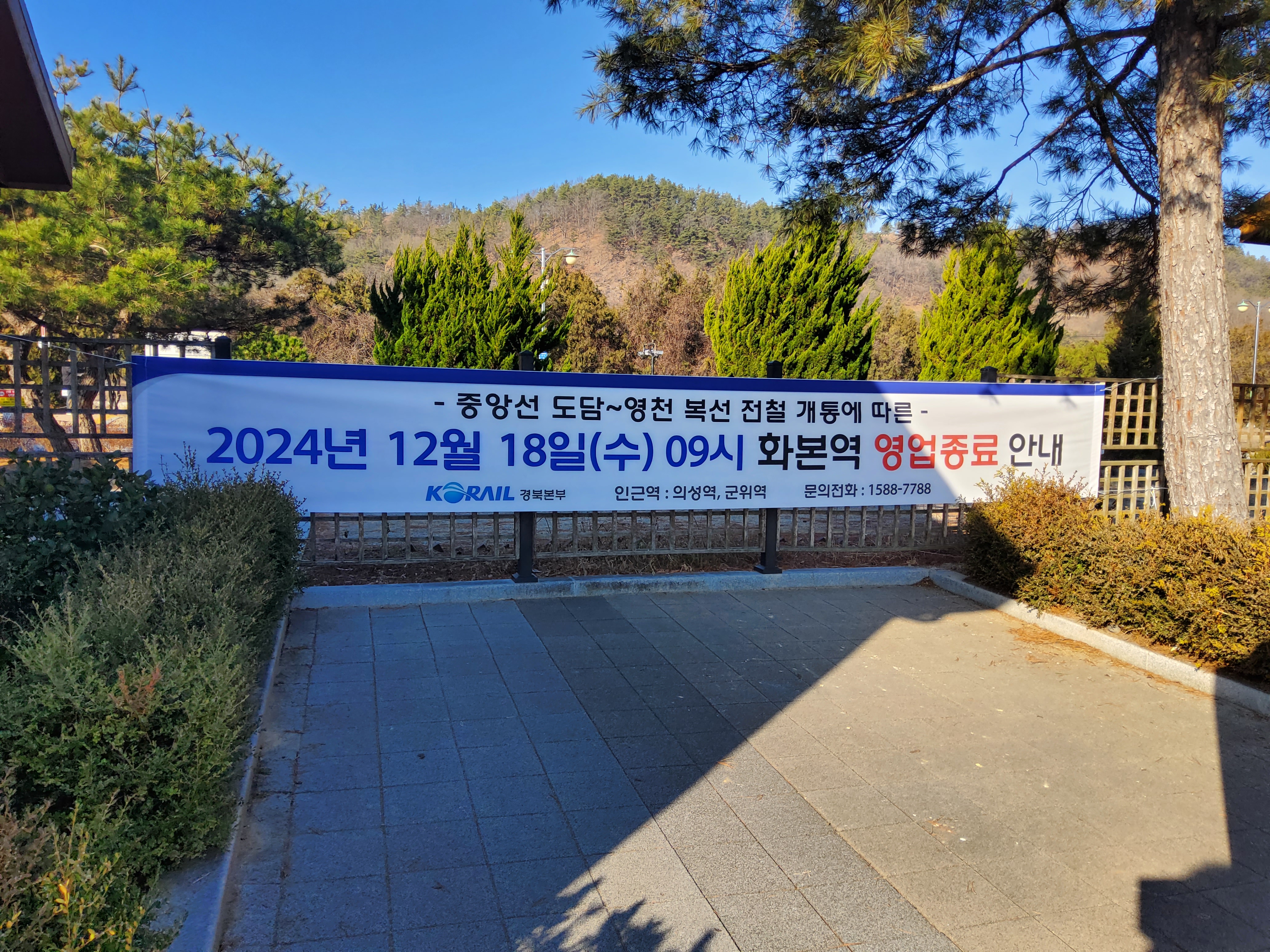

아래 사진은 같은날 오전 화본역을 둘러보다 몇장 찍어본것들입니다.

300x250

'좌충우돌 여행기 > 국내여행' 카테고리의 다른 글

| 포항 영일만 바닷가를 옆에 두고 - 영일만항선 영일만항역(2025.04.01) (0) | 2025.04.03 |

|---|---|

| 중앙선 이설전 마지막 풍경들 - 의성역~우보역 구간(2024.12.01) (0) | 2024.12.06 |

| 중앙선 이설전 마지막 풍경들 - 북영천역~갑현역 구간(2024.11.22) (0) | 2024.11.23 |

| 중앙선에 남은 마지막 아담한 간이역 - 화본역(2024.07.27) (0) | 2024.09.30 |

| 뒤바뀐 운명 - 중앙선 건천역과 아화역(2024.07.27) (0) | 2024.07.28 |

설정

트랙백

댓글

글

중앙선 이설전 마지막 풍경들 - 의성역~우보역 구간(2024.12.01)

좌충우돌 여행기/국내여행

2024. 12. 6. 19:06

중앙선 전구간 이설이 완료되기 약 3주 정도 남은 시점에 곧 사라지게 될 풍경들을 사진에 남겨보고자 한 번 더 다녀와보았습니다. 이번에는 의성역~우보역 구간을 돌아다녀 보았습니다.

이화건널목

시간표를 확인하지 않고 오는 바람에 2시간 정도 기다리게 되었습니다. 남는 시간동안 동네를 돌아다녀봅니다.

군위가 귀산 박씨 집성촌인듯 보입니다.

낮선 외지인을 반기는 강아지

우보역

철길을 둘러보던 도중 길가 한복판에 우보역을 발견하였습니다.

역내에 상주하는 직원이 있는지 출입문이 막혀있지는 않았습니다.

우보역 시비

플랫폼은 영업하던 시절 그대로 유지되는듯 보입니다.

승강장으로 진입하는 건널목은 철거되어 있습니다.

역 구내를 둘러보고 바로 옆에 있는 건널목으로 이동합니다.

금천건널목

철길이 도로 바로 옆에 붙어있어 구도가 잘 나올거같습니다.

대리건널목

탑리역에서 의성역 방면으로 가면 처음으로 볼 수 있는 대리건널목

마을길 바로 옆을 따라가는 철길

만천건널목

300x250

'좌충우돌 여행기 > 국내여행' 카테고리의 다른 글

| 포항 영일만 바닷가를 옆에 두고 - 영일만항선 영일만항역(2025.04.01) (0) | 2025.04.03 |

|---|---|

| 2024년의 끝을 앞두고 사라지다 - 중앙선 북영천역(+화본역) (0) | 2024.12.16 |

| 중앙선 이설전 마지막 풍경들 - 북영천역~갑현역 구간(2024.11.22) (0) | 2024.11.23 |

| 중앙선에 남은 마지막 아담한 간이역 - 화본역(2024.07.27) (0) | 2024.09.30 |

| 뒤바뀐 운명 - 중앙선 건천역과 아화역(2024.07.27) (0) | 2024.07.28 |

설정

트랙백

댓글

글

중앙선 이설전 마지막 풍경들 - 북영천역~갑현역 구간(2024.11.22)

좌충우돌 여행기/국내여행

2024. 11. 23. 21:22

다음달(2024년 12월 21일) 중앙선의 모든 구간 이설이 완공되어 KTX가 서울 청량리역에서부터 부산 부전역까지 달릴 예정입니다. 즉, 현재 마지막으로 남은 기존선 구간(안동 - 북영천) 또한 다음달부터는 열차가 더이상 달리지 않을 예정입니다.

차후 이설되어 볼 수 없게될 풍경들을 사진으로 남기고자 날씨가 화창하던날 마지막으로 남은 중앙선 기존구간을 다녀왔습니다.

첫 번째로 방문한 곳은 북영천역에서 출발한 열차가 처음으로 건널목을 통과하는 호당4건널목입니다.

호당4건널목

운좋게 도착하자마자 열차가 지나가는 것을 사진으로 남기는군요.

호당3건널목

호당2건널목

삼부건널목

화산역

화산역 광장에서 바라본 입구길. 역 바로 옆에 붉은 철문의 구 역세권 집이 인상적이었습니다.

역 내부를 보니 꽤 오래전 폐쇄된 흔적들을 볼 수 있었습니다.

유성1건널목

유성1건널목에서 바라본 화산역 구내

화남건널목

완전3건널목

주변에 건널목밖에 없는 이 곳에 새마을운동 기념 공원이 있었습니다.

왕복 4차선 도로가 이 건널목에서만 2차선으로 줄어듭니다. 아마도 선로이설 후 추가 공사를 하겠죠

공원에서 쉬다가 기차 구경하기는 딱 좋은 곳이었습니다.

하지만 내년부터는 이 곳에서 더이상 열차를 볼 수 없게 됩니다.

내년이면 이 곳도 4차선으로 확장되어 지금의 흔적은 볼 수 없을 것으로 보입니다.

신덕2건널목

한적한 시골 입구에 위치한 신덕2건널목입니다

마을 주변을 돌아다니던 도중 요란한 소리가 울려퍼지고

신녕역을 출발한 열차가 들어옵니다.

열차가 떠난 직후 모습

용천건널목

가일1건널목

왠지 침목으로 만든것으로 추정됩니다.

석촌2건널목

건널목 인근 회사에서 키우는 강아지가 일을 열심히 하는군요.

300x250

'좌충우돌 여행기 > 국내여행' 카테고리의 다른 글

| 2024년의 끝을 앞두고 사라지다 - 중앙선 북영천역(+화본역) (0) | 2024.12.16 |

|---|---|

| 중앙선 이설전 마지막 풍경들 - 의성역~우보역 구간(2024.12.01) (0) | 2024.12.06 |

| 중앙선에 남은 마지막 아담한 간이역 - 화본역(2024.07.27) (0) | 2024.09.30 |

| 뒤바뀐 운명 - 중앙선 건천역과 아화역(2024.07.27) (0) | 2024.07.28 |

| 추운 겨울 한적한 마을에 역이 다시 들어서다 - 경의선 운천역[2022.12.18] (0) | 2022.12.23 |